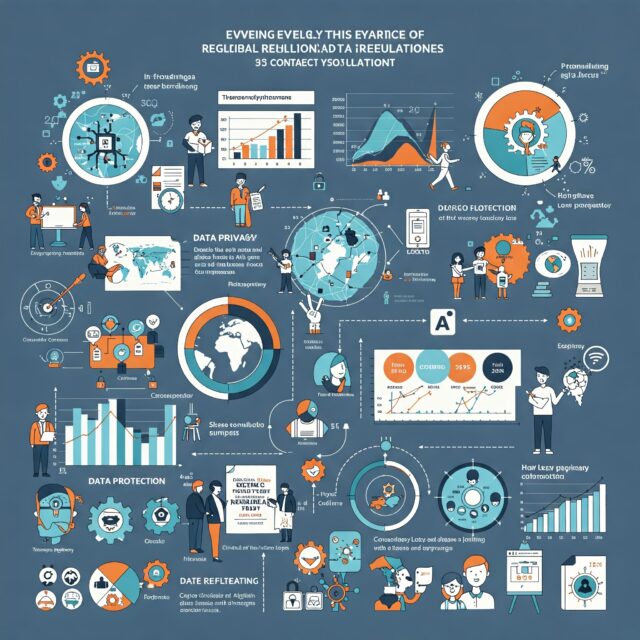

Introducción: la privacidad en la era de la inteligencia artificial

Vivimos en una era hiperconectada, donde cada clic, búsqueda o voz grabada genera datos. La llegada de la inteligencia artificial ha acelerado este fenómeno: los algoritmos procesan cantidades masivas de información personal para predecir, recomendar, automatizar y decidir.

Esto ha encendido las alarmas en todo el mundo sobre la privacidad, el uso ético de los datos y la necesidad urgente de regulación. La respuesta ha sido una oleada de leyes globales que buscan equilibrar innovación y protección, como el Reglamento General de Protección de Datos (GDPR) en Europa o la emergente Ley de IA de la Unión Europea (AI Act).

¿Por qué es crítica la regulación en el contexto de la IA?

La inteligencia artificial necesita datos para aprender y mejorar. Pero cuando esos datos son personales o sensibles (salud, ubicación, preferencias, rostro, voz), surgen riesgos como:

- ❌ Discriminación algorítmica

- ❌ Vigilancia masiva

- ❌ Pérdida de control sobre los datos propios

- ❌ Violaciones de privacidad sin consentimiento claro

Las regulaciones buscan proteger los derechos fundamentales, asegurar la transparencia, y limitar los usos abusivos o peligrosos de la IA.

1. La Ley de IA de la Unión Europea (EU AI Act)

Es la primera legislación integral del mundo enfocada exclusivamente en la inteligencia artificial. Aprobada en 2024 y en fase de implementación, clasifica los sistemas de IA por nivel de riesgo:

Categorías clave:

- 🔴 Riesgo inaceptable: prohibidos (manipulación subliminal, puntuación social como en China).

- 🟠 Alto riesgo: sujetos a evaluación estricta (IA en justicia, salud, seguridad pública).

- 🟡 Riesgo limitado: deben ofrecer transparencia (chatbots, asistentes virtuales).

- 🟢 Riesgo mínimo: sin restricciones (videojuegos, filtros de redes sociales).

Requisitos para IA de alto riesgo:

- Evaluaciones de impacto

- Trazabilidad y documentación técnica

- Supervisión humana

- Datos de entrenamiento de calidad y sin sesgos

Impacto global: se espera que muchas empresas fuera de Europa adapten sus productos para cumplir con esta ley, como pasó con el GDPR.

2. Regulaciones en Estados Unidos

EE.UU. no tiene una ley nacional unificada como el GDPR, pero sí marcos parciales y propuestas en avance:

Normas relevantes:

- California Consumer Privacy Act (CCPA): da derechos a los consumidores sobre sus datos personales.

- AI Bill of Rights (propuesta): orientaciones sobre el uso justo y ético de la IA.

- NIST AI Risk Management Framework: guía voluntaria para gestionar riesgos de IA.

- Executive Order (2023): regulación del uso de IA en agencias federales.

La tendencia en EE.UU. apunta a regulación sectorial, orientada al riesgo, y con fuerte impulso desde el sector privado.

3. Otros marcos regulatorios internacionales

🔹 Reino Unido

- Estrategia centrada en innovación responsable.

- Regulación flexible, adaptativa y sectorial.

🔹 China

- Enfocada en control estatal y seguridad nacional.

- Reglas estrictas para algoritmos de recomendación y deepfakes.

🔹 Canadá, Brasil, Japón

- Avanzan en marcos éticos y regulatorios de IA, con diferentes grados de madurez.

🔹 América Latina

- Países como Argentina, México, Chile o Colombia están diseñando leyes de datos personales y estrategias de IA en fase temprana.

4. ¿Qué implica esto para las empresas y desarrolladores?

- ⚖️ Cumplimiento normativo obligatorio si operan en países regulados (como la UE).

- 📋 Necesidad de auditar sistemas de IA para detectar sesgos o discriminación.

- 🔐 Protección y anonimización de datos sensibles.

- 🧩 Documentación clara de algoritmos y modelos.

- 🧠 Inclusión de la ética y la transparencia desde la fase de diseño (principio de “privacy by design”).

5. Impacto en los usuarios: más derechos, más control

Los marcos regulatorios buscan que los usuarios puedan:

- ✅ Saber cuándo interactúan con una IA.

- ✅ Revocar decisiones automáticas que les afecten.

- ✅ Controlar qué datos se recopilan, y cómo se usan.

- ✅ Denunciar abusos o discriminación algorítmica.

- ✅ Ser informados de manera clara y accesible.

6. IA, privacidad y el futuro

En los próximos años veremos:

- Auditorías obligatorias de sistemas de IA en sectores clave.

- Certificaciones de conformidad legal y ética.

- Sanciones por violaciones de privacidad algorítmica.

- Mayor participación ciudadana y transparencia tecnológica.

La privacidad ya no es solo un tema legal o técnico: es una piedra angular de la confianza digital en la era de la inteligencia artificial.

Conclusión: regular para proteger sin frenar la innovación

La regulación no es el enemigo de la IA, sino su compañera necesaria para que el desarrollo tecnológico esté alineado con los derechos humanos, la equidad y la justicia.

Tanto la Ley de IA de la UE como las propuestas en EE.UU. y otras regiones marcan el inicio de un nuevo marco global donde la privacidad, la seguridad y la ética son parte integral del diseño y uso de sistemas inteligentes.

Preguntas frecuentes (FAQ)

¿La Ley de IA de la UE afecta a empresas fuera de Europa?

Sí, si ofrecen productos o servicios en el mercado europeo, deben cumplir sus requisitos.

¿Es legal que una IA tome decisiones sobre personas?

Depende del país y del contexto. En muchos casos, debe haber posibilidad de revisión humana y consentimiento informado.

¿Qué pasa si una empresa incumple estas leyes?

Podría enfrentar multas millonarias, prohibición de uso de productos y daños reputacionales.